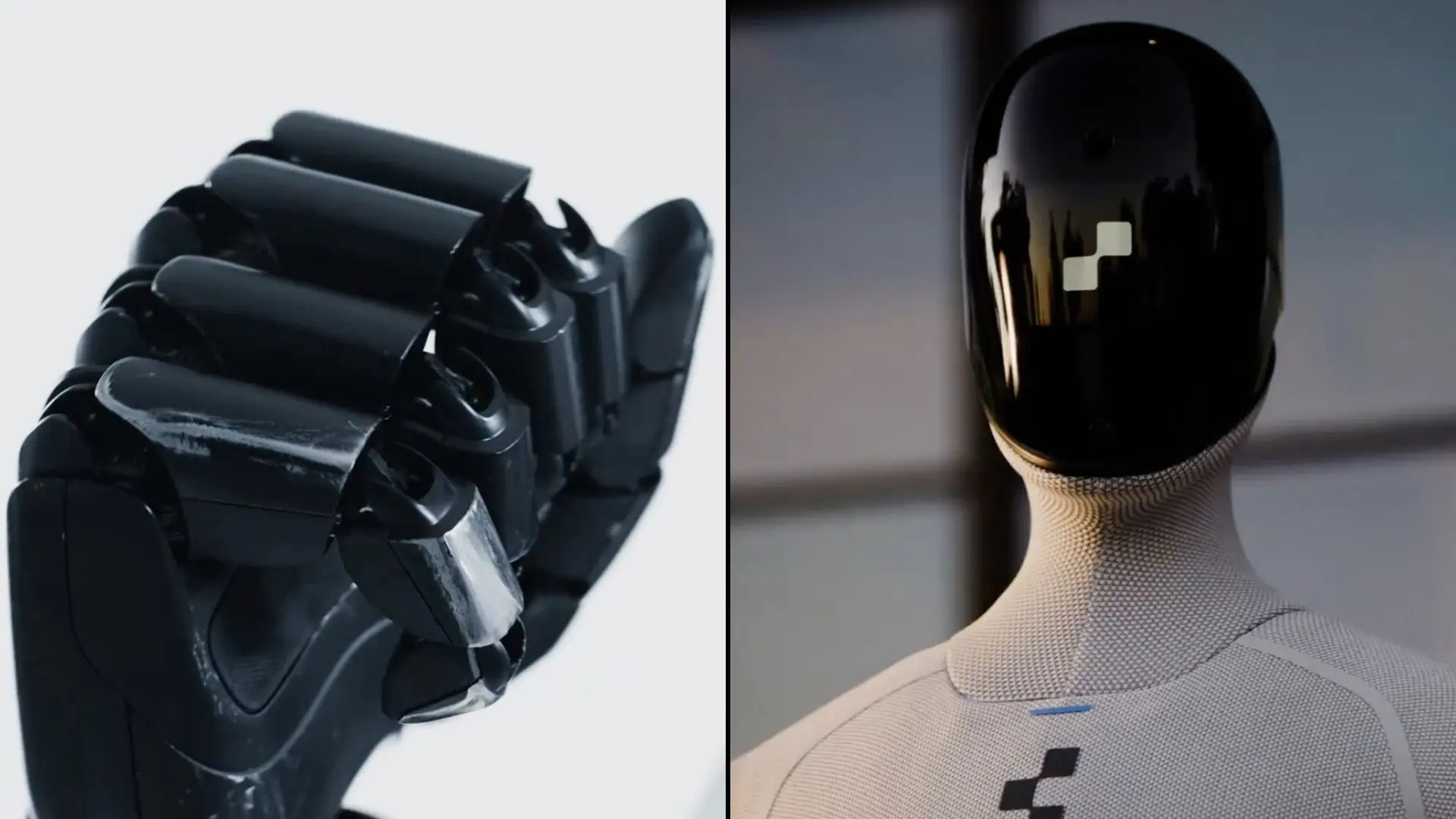

یکی از شرکتهای برتر در حوزه تولید رباتهای انساننما به نام Figure AI که در کالیفرنیا قرار دارد، توسط رئیس سابق بخش ایمنی محصول خود مورد شکایت قرار گرفته است. رابرت گروئندول (Robert Gruendel) ادعا میکند که پس از هشدار به مدیران ارشد Figure AI مبنیبر اینکه محصولات این شرکت قادر به ایجاد آسیبهای فیزیکی شدید هستند، اخراج شده است. براساس این شکایت که در کالیفرنیا ثبت شده، مهندس نام برده چند روز پس ارائه آنچه که او “صریحترین و مستندترین شکایات مربوط به ایمنی” توصیف کرده، از شرکت اخراج شده است.

طبق این دادخواست، گروئندل به مدیرعامل شرکت، برت ادکاک (Brett Adcock) و مهندس ارشد آن، کایل ادلبرگ (Kyle Edelberg) هشدار داده بود که رباتهای Figure AI قدرت کافی برای شکستن جمجمه انسان دارند و به حادثهای اشاره کرده بود که در آن ظاهرا یکی از رباتها در اثر نقص فنی، شکافی با اندازه یک چهارم اینچی روی درب فولادی یخچال ایجاد کرده بود. در پرونده حقوقی گروئندل آمده است که توجهی به نگرانیهای او نشده و به عنوان موانع، نه تعهدات تلقی شدهاند. سپس به این مهندس گفته شد که او به دلیل تغییری مبهم در مسیر تجاری شرکت، از کار برکنار شده است.

باتوجه به یکی از گزارشات خبرگزاری CNBC، سخنگوی Figure AI این ادعاها را از طریق ایمیل رد نمود و گفت: “گروئندل به دلیل عملکرد ضعیفش اخراج شده است و حرفهای دروغهایی هستند که شرکت ما آنها را در دادگاه بیاعتبار خواهد کرد.” ظاهرا گروئندل به دنبال غرامت اقتصادی و مجازات شرکت مذکور است؛ او همچنین میخواهد هیئت منصفه افراد خاطی در این زمینه را محاکمه کند. وکیل این مهندس، رابرت اوتینگر (Robert Ottinger) به CNBC گفت قانون کالیفرنیا از کارکنانی که شیوههای کاری ناایمن را گزارش میدهند، حمایت میکند و افزود این پرونده ممکن است یکی از اولین پروندههای افشاگری در رابطه با ایمنی رباتهای انساننما باشد.

او گفت موکلش امیدوار است که روند قضایی خطر آشکاری را که این رویکرد شتابزده برای مردم به همراه دارد را آشکار سازد. این دادخواست تنها دو ماه پس از آن مطرح شده است که ارزشگذاری Figure AI در یک جلسه سرمایهگذاری به رهبری موسسه Parkway Venture Capital به ۳۹ میلیارد دلار افزایش یافت. این یک جهش ۱۵ برابری نسبت به اوایل سال ۲۰۲۴ است، زمانی که سرمایهگذارانی مانند جف بزوس، انویدیا و مایکروسافت در دور قبلی سرمایهگذاری شرکت کرده بودند.

نگرانیها درباره نقشه راه ایمنی و اطلاعات سرمایهگذارن Figure AI

در شکایت گروئندل همچنین ادعا شده که شرکت Figure AI طرح ایمنیای که او برای دو سرمایهگذار بزرگ بالقوه تهیه کرده بود، نابود کرده است؛ همان دو سرمایهگذاری که بعدها در این کمپانی سرمایهگذاری کردند. در این پرونده گفته شده که حذف بخشهای کلیدی از طرح ایمنی محصول که در تصمیم آنها برای سرمایهگذاری نقش داشته است، میتواند به عنوان فریبکاری تعبیر شود. گروئندل مدعی شده که به رئیس شرکت اصرار کرده است نقشه راه ایمنی را تغییر ندهند، اما پس از انجام سرمایهگذاری، نگرانیهای او نادیده گرفته شدند. این پرونده نشان میدهند که در محیط کاری، مطرح کردن مسائل ایمنی خوشایند نبوده و در نهایت منجر به اخراجی شده است که شاکی آن را تلافیجویانه توصیف کرده است.

این ادعاها که توسط لورا کولودنی (Lora Kolodny) از CNBC گزارش شده، به خطرات ایمنی فیزیکی در حوزه تولید رباتهای انساننما که به سرعت در حال پیشرفت است، اشاره دارند. در حالی که بسیاری از بحثهای عمومی درباره هوش مصنوعی بر آسیبهای نرمافزاری متمرکز بودهاند، ادعاهای مطرح شده علیه Figure AI درباره خطرات فیزیکی هستند که میتوانند با توانمندتر شدن بیشتر رباتها و گسترش استفاده از آنها بهوجود آیند.

تاریخچه حوادث ایمنی مرتبط با رباتها

اگرچه رباتهای انساننما هنوز در مراحل اولیه توسعه قرار دارند، اما رباتهای صنعتی در طول سالها در چندین حادثه مرگبار نقش داشتهاند. حوادثی در کارخانههای تولیدی مانند یک مورد گزارششده در کارخانه فولکس واگن آلمان در سال ۲۰۱۵ و یکی از نخستین مرگهای مرتبط با ربات در ژاپن در سال ۱۹۸۱، خطراتی که توسط دستگاههای خودکار قدرتمند ایجاد میشوند را نشان میدهند. یکی از پرسروصداترین موارد، مربوط به یک مهندس نرمافزار تسلا در ابرکارخانه تسلا در آستین تگزاس است. در سال ۲۰۲۱، او توسط یک بازوی رباتیک معیوب مورد حمله قرار گرفت و مجروح شد. براساس گزارشها، این بازو او را گیر انداخته و چنگالهایش را در پشت و بازوی او فرو کرده است، درست پیش از اینکه یکی از همکارانش دکمه توقف اضطراری را فشار دهد.

سایر حوزههای صنعت فناوری نیز شاهد اختلافات گستردهای درباره هشدارهای ایمنی داخلی بوده است. در سال ۲۰۲۰، دکتر تیمنیت گبرو (Timnit Gebru)، محقق برجسته در زمینه رفتار هوش مصنوعی، گفت که پس از ابراز نگرانی درباره خطرات ناشی از مدلهای زبانی بزرگ، اخراج شده است. افزونبر این، در طول سالها، چندین مهندس و تحلیلگر ایمنی، شرکت بوئینگ را متهم کردهاند که هشدارهای داخلی درباره سیستم کنترل پرواز هواپیمای ۷۳۷ مکس را نادیده گرفته است؛ آنها فرهنگ بهرهگیری از مردم را عامل مشکلات طراحی و تولید دانستهاند.

با تکامل فناوری رباتهای انساننما، شکایت مطرحشده علیه شرکت Figure AI نشاندهنده تغییر ماهیت مباحث ایمنی از خطرات الگوریتمی انتزاعی به سوالات فوری درباره چگونگی تعامل دستگاههای قدرتمند با محیطهای انسانی است. این پرونده اکنون به دادگاه منتقل میشود، جایی که گروئندل و Figure AI روایتهای متضادی درباره فرهنگ محیط کار شرکت و ایمنی رباتهای آن ارائه خواهند شد.

دانلود آهنگ

دیدگاهتان را بنویسید