محقق ایمنی ChatGPT از OpenAI استعفا داد. این محقق در راستای اتفاقات اخیر که در حوزه هوش مصنوعی و پروژه DeepSeek افتاده، چنین تصمیمی گرفت.

بهگزارش تکراتو به نقل از bgr، این روزها اخبار مربوط به هوش مصنوعی تحت تاثیر پروژهای به نام DeepSeek قرار گرفته است. دیپسیک یک استارتاپ چینی است که موفق شده مدلی برای استدلال و پردازش اطلاعات ارائه دهد که از نظر توانایی با ChatGPT برابری میکند، آن هم بدون در اختیار داشتن زیرساختها و سختافزارهای عظیمی که OpenAI از آنها بهره میبرد.

این شرکت برای آموزش مدل DeepSeek R1 از تراشههای قدیمیتر و بهینهسازیهای نرمافزاری استفاده کرده است.

اتهاماتی که OpenAI دربارهی احتمال استفادهی DeepSeek از نسخهی تقطیرشدهی ChatGPT برای آموزش مدلهای اولیهی R1 مطرح کرده، عملا اهمیتی ندارد.

پروژهی دیپسیک احتمالا در چندین جبهه به اهدافش رسیده است. این پروژه رقابت در حوزهی هوش مصنوعی را متعادلتر کرده و به چین فرصت داده تا در این عرصه رقابت کند. همچنین، این پروژه باعث سقوط ارزش بازار سهام آمریکا به میزان نزدیک به یک میلیارد دلار شد، بهطوری که شرکتهای سختافزار مرتبط با هوش مصنوعی بیشترین ضرر را متحمل شدند.

علاوه بر این، DeepSeek به چین یک سلاح نرمافزاری داده که حتی ممکن است از تیکتاک هم قدرتمندتر باشد. این مدل هماکنون محبوبترین اپلیکیشن در فروشگاه اپ استور است. از همه مهمتر، هر کسی میتواند مدل DeepSeek را روی کامپیوتر شخصی خود نصب کند و از آن برای ساخت مدلهای دیگر استفاده کند.

محقق ایمنی ChatGPT میگوید: «نگران آیندهی بشریت هستم»

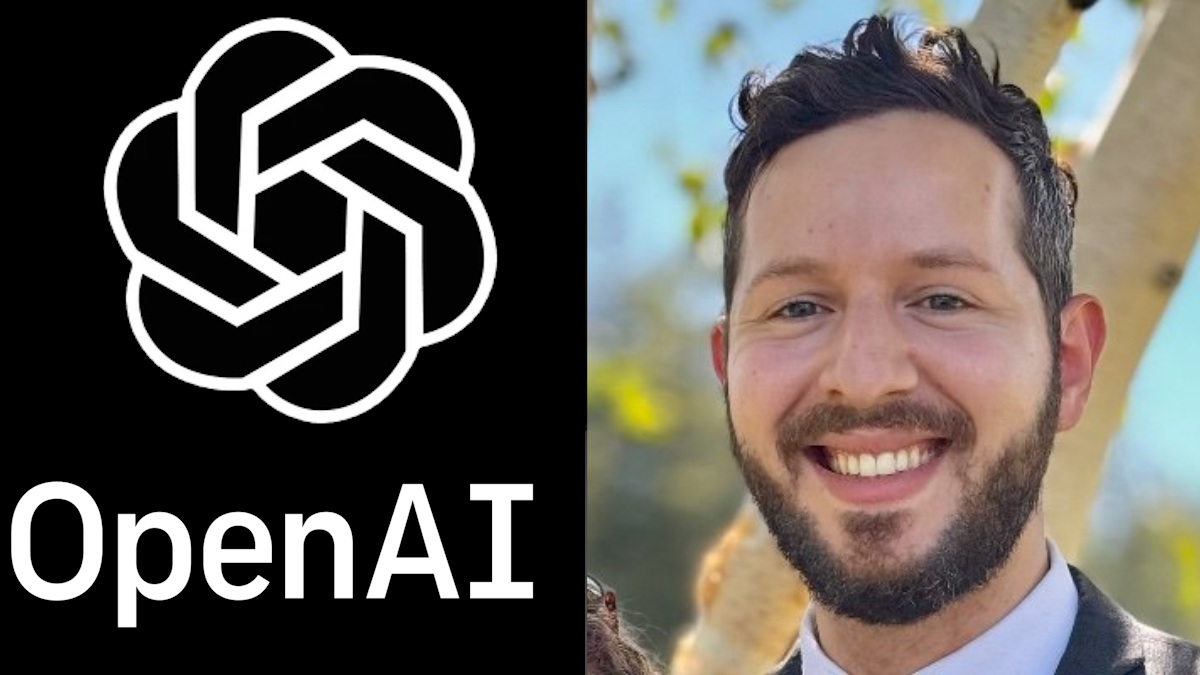

با وجود همهی این تحولات، ممکن است متوجه خبر دیگری نشده باشید: اینکه محقق ایمنی ChatGPT که در حوزهی ایمنی OpenAI فعالیت میکرده استعفا داده است. استیون آدلر به فهرست روبهرشد مهندسانی پیوست که در سال گذشته این شرکت را ترک کردهاند.

جالب اینجاست که آدلر در اواسط نوامبر OpenAI را ترک کرده بود، اما خبر استعفای خود را روز دوشنبه، درست زمانی که اخبار مربوط به DeepSeek بازار را دچار نوسان کرد، علنی کرد.

آدلر در شبکهی اجتماعی X اعلام کرد که پس از چهار سال شرکت را ترک میکند. او نوشت:

«این تجربه سفری پر فراز و نشیب بود با بخشهای مختلفی مثل ارزیابی قابلیتهای خطرناک، ایمنی و کنترل عوامل هوش مصنوعی، هوش مصنوعی عمومی (AGI) و هویت آنلاین و …؛ من دلم برای خیلی از بخشهای آن تنگ خواهد شد.» اما پس از آن، اظهارنظری نگرانکننده مطرح کرد.

او افزود:

«من واقعا از سرعت پیشرفت هوش مصنوعی در این روزها وحشتزده هستم.»

این جمله بازتابی از نگرانیهای سایر کارشناسان هوش مصنوعی است که معتقدند این فناوری امکان دارد سرنوشت بشریت را به خطر بیندازد. این محقق سابق OpenAI بدون پردهپوشی گفت که نسبت به آینده احساس نگرانی دارد.

او نوشت:

«وقتی به این فکر میکنم که کجا باید در آینده خانوادهای تشکیل دهم یا چقدر برای بازنشستگی پسانداز کنم، نمیتوانم نادیده بگیرم که آیا اصلاً بشریت تا آن زمان دوام خواهد آورد یا نه.»

آیا آدلر شاهد پیشرفت AGI در OpenAI بوده است؟

یکی از سوالات مهم این است که آدلر در OpenAI چه چیزی دیده که باعث شده شرکت را ترک کند؟ و چرا نماند تا شاید بتواند به ایمنسازی هوش مصنوعی کمک کند؟

ممکن است آدلر شاهد پیشرفتهای مهمی در حوزهی AGI (هوش مصنوعی جامع) در OpenAI بوده باشد، چرا که این شرکت به وضوح در حال کار روی چنین فناوریای است. البته شاید! اما یک توییت دیگر از او به این موضوع اشاره دارد.

آدلر نوشت:

«مسابقه برای AGI یک قمار بسیار خطرناک با تبعات منفی عظیم است. هیچ آزمایشگاهی در حال حاضر راهحلی برای تنظیم و همسو کردن هوش مصنوعی (AI Alignment) ندارد و هر چه سرعت رقابت بیشتر شود، احتمال یافتن یک راهحل بهموقع کمتر خواهد شد.»

احتمالا OpenAI در حال افزایش سرعت رقابت در این حوزه است. AGI نوعی هوش مصنوعی است که از نظر توانایی حل مسئله، خلاقیت و اطلاعات میتواند با انسان رقابت کند، اما برتری آن در این است که دانش بیشتری نسبت به انسان دارد و میتواند مسائل را کارآمدتر حل کند.

یکی از مهمترین مسائل در زمینهی ایمنی هوش مصنوعی، همسوسازی (Alignment) آن با منافع بشری است. این تنها راهی است که میتواند تضمین کند هوش مصنوعی اهدافی خارج از کنترل بشر دنبال نکند و سرنوشت ما را به خطر نیندازد.

اما محصولاتی مانند ChatGPT و DeepSeek دو نمونه از رویکردهای متفاوت به همسوسازی را به ما نشان میدهند. به نظر میرسد که ChatGPT با منافع آمریکا و غرب همسو شده در حالی که DeepSeek با منافع چین تنظیم شده و این همسویی از طریق سانسور اعمال میشود.

رقابت آزمایشگاههای هوش مصنوعی و خطرات احتمالی

آدلر در اظهارات خود بهطور غیرمستقیم به DeepSeek اشاره کرد و نوشت:

«امروز، به نظر میرسد که در یک تعادل بسیار بد گرفتار شدهایم. حتی اگر یک آزمایشگاه واقعا بخواهد AGI را بهطور مسئولانه توسعه دهد، دیگران میتوانند از مسیرهای میانبر استفاده کنند تا عقب نمانند، که این ممکن است فاجعهبار باشد. این موضوع باعث میشود همهی آزمایشگاهها سرعت کار خود را افزایش دهند. امیدوارم که این آزمایشگاهها بهطور صریح دربارهی ملاحظات ایمنی واقعی که برای جلوگیری از این وضعیت لازم است، صحبت کنند.»

چرا این موضوع مهم است؟ چون مدل متنباز DeepSeek R1 در دسترس همگان قرار دارد. افراد سودجو، با داشتن منابع و دانش کافی، ممکن است ناخواسته به AGI دست پیدا کنند؛ بدون اینکه بدانند چه چیزی خلق کردهاند یا متوجه باشند که چه خطراتی ممکن است بهوجود بیاورند.

شاید این شبیه به یک سناریوی علمیتخیلی به نظر برسد، اما احتمال وقوع آن وجود دارد. همانطور که امکان دارد یک شرکت بزرگ هوش مصنوعی، AGI را توسعه دهد و هشدارهای محققان ایمنی را نادیده بگیرد، در حالی که این محققان یکی پس از دیگری شرکت را ترک میکنند.

مشخص نیست که آدلر در آینده به کجا خواهد رفت، اما به نظر میرسد همچنان به موضوع ایمنی هوش مصنوعی علاقه دارد. او در شبکهی اجتماعی X از مردم پرسید که «مهمترین و مغفولترین ایدهها در ایمنی و سیاستگذاری هوش مصنوعی چه هستند؟» و افزود که به روشهای کنترلی، شناسایی اقدامات مخرب، و پروندههای ایمنی علاقهمند است.

ChatGPT

دانلود آهنگ

دیدگاهتان را بنویسید